发布时间:2025-12-08

2025年12月5日, Neurocomputing期刊在线发表了题为《Towards Biologically Plausible DNN Optimization: Replacing Backpropagation and Loss Functions with a Top-Down Credit Assignment Network》的研究论文。该研究由中国科学院脑科学与智能技术卓越中心、脑认知与类脑智能全国重点实验室王佐仁研究组王佐仁研究组联合中国科学院自动化研究所刘成林研究组共同完成。团队提出了一种全新的类脑学习框架:自顶向下信用分配网络框架(TDCA,Top-Down Credit Assignment Network),首次利用脑启发的自顶向下调控网络,同时替代传统人工智能中的损失函数与反向传播算法,在多种任务中实现了更快收敛、更强稳定性和更低计算成本的学习性能。

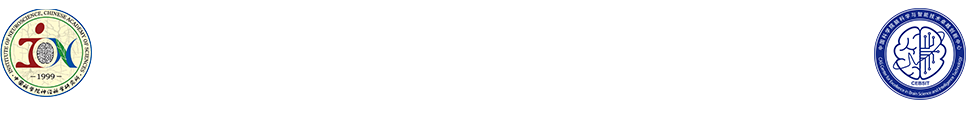

图1:不同的学习方式比较:传统人工智能优化,生物大脑以及TDCA网络方法

长期以来,人工智能的成功依赖“损失函数+ 反向传播”这一经典训练范式。然而,一个根本性问题始终存在:人脑并不是通过反向传播学习的,那么大脑究竟是如何实现高效学习的?如果人工智能也不使用反向传播,它还能否学会复杂任务?在传统人工智能中,损失函数由人类显式设计,误差信号通过反向传播逐层精确计算。然而,神经科学研究表明:大脑中并不存在显式的数值损失函数;也不存在类似反向传播那样的精确梯度回传机制;真正起关键作用的,很可能是来自前额叶、扣带回等高级认知脑区的自顶向下调控信号。这提示,除了传统“误差回传”机制之外,大脑中可能还存在一种内源性的学习调控方式。

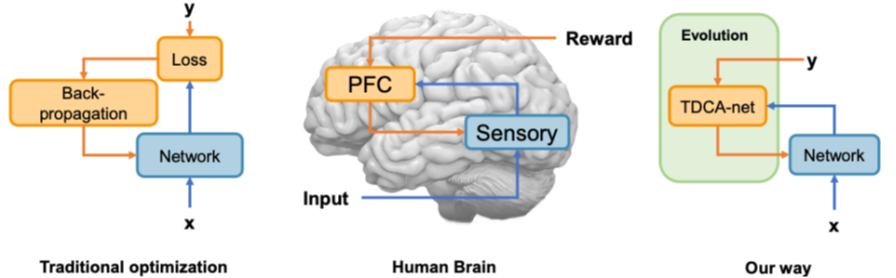

图2.TDCA网络整体训练框架

基于上述神经生物学证据,研究团队提出了TDCA 自顶向下信用分配网络框架。该框架由两个网络构成:一个负责执行任务的底层任务网络,以及一个负责生成学习信号的自顶向下调控网络。不同于传统方法中“先定义损失函数、再进行反向传播”,TDCA 框架中:自顶向下网络直接生成用于更新参数的学习信号,从而整体替代了损失函数和反向传播。该框架在机制上模拟了大脑中高级脑区对低级脑区的调控作用,使人工神经网络的学习方式在整体结构上更接近生物大脑。

研究团队在多个代表性任务中对TDCA 框架进行了系统验证,包括:非凸函数优化任务(传统算法易陷入局部最优)、图像分类任务(MNIST、Fashion-MNIST)、和强化学习任务(CartPole、Pendulum、BipedalWalker、MetaWorld 机械臂控制)。实验结果表明,TDCA 框架具有以下显著优势:收敛更快,更容易跳出局部最优;对初始参数不敏感,稳定性更强;可迁移到新任务,具备良好泛化能力;在多项任务中整体性能优于传统反向传播算法及多种生物可实现学习方法。尤其在强化学习和机器人控制任务中,同一个自顶向下网络可以同时指导多个不同任务的学习,展现出类似大脑“通用学习策略”的特征。

该研究不仅在算法层面实现重要突破,也在类脑人工智能与计算神经科学领域具有深远意义:为下一代类脑人工智能系统提供全新训练范式;为低功耗智能芯片提供适配型学习机制;为真实大脑学习机制建模提供新的计算框架;并且为机器人与强化学习系统提供更高效的学习策略。从长远来看,该工作为构建真正“像大脑一样学习”的人工智能系统提供了一条全新的技术路径。

脑智卓越中心特聘研究助理陈建辉博士为该论文的第一作者,王佐仁、刘成林研究员为该论文的共同通讯作者,杨天明研究员对论文做出重要贡献。该工作得到中国科学院战略先导专项、科技创新2030重大项目的支持。

附件下载:

附件下载: